Publicité

Si vous avez les ficelles mentales, un flair pour la programmation et la narration, et un œil pour la conception, vous pouvez faire pire que de vous lancer dans la science des données. C’est la nouvelle grande technologie; très à la mode et très bien payé, les scientifiques des données étant recherchés par certaines des plus grandes entreprises du monde.

ScraperWiki est une entreprise qui est depuis longtemps associée au domaine de la science des données. Au cours des dernières années, cette startup basée à Liverpool a offert une plate-forme aux codeurs pour écrire des outils qui obtiennent des données, les nettoient et les analysent dans le cloud.

Avec un rafraîchissement récent et la demande toujours croissante de scientifiques des données dans l'entreprise, il vaut la peine de jeter un coup d'œil à ScraperWiki.

Divulgation complète: j'étais stagiaire chez ScraperWiki l'été dernier.

Que fait ScraperWiki?

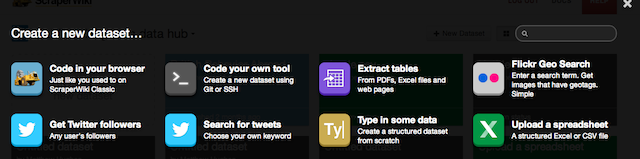

ScraperWiki se présente comme un endroit pour obtenir, nettoyer et analyser les données, et il livre sur chacun de ces points. Dans sa forme la plus simple, il vous permet - à l'utilisateur - un endroit où vous pouvez écrire du code qui récupère les données d'une source, des outils pour convertir il dans un format qui est facile à analyser, et le stockage pour le conserver pour une visualisation ultérieure - que vous pouvez également gérer avec ScraperWiki.

Il est également livré avec un certain nombre d'outils prédéfinis qui automatisent les tâches répétitives, notamment obtenir des données à partir de PDF, qui sont notoirement difficiles à décoder. Ceci s'ajoute à Recherche sur Twitter 5 astuces de recherche sur Twitter pour surveiller ce que les gens disent de vousSi vous possédez un site Web ou essayez simplement de gagner de l'argent en ligne en tant que pigiste, il est toujours bon de savoir ce que les gens disent de vous sur Internet. Les gens citent peut-être ... Lire la suite et les utilitaires de grattage. Vous n'avez besoin d'aucune expérience en développement logiciel pour les utiliser.

Coût

Comme mentionné précédemment, ScraperWiki adopte le modèle de tarification freemium et propose un service à plusieurs niveaux. Ceux qui commencent tout juste avec la science des données ou avec des besoins limités peuvent utiliser le service gratuit. Cela vous donne trois ensembles de données - où vous stockez vos données et votre code.

Ceux qui envisagent d'écrire plusieurs grattoirs ou qui souhaitent faire des montagnes d'analyse de données peuvent débourser de l'argent pour un compte premium. Ceux-ci commencent à 9 $ par mois et offrent 10 ensembles de données. Si cela ne suffit toujours pas, vous pouvez toujours passer à leur niveau le plus élevé, qui comprend 100 jeux de données et coûte 29 $ par mois.

Codage

Les programmeurs sont souvent très particuliers en ce qui concerne la façon dont ils codent. Certains préfèrent les langages de script aux langages compilés. Certains préfèrent l'expérience simplifiée d'un éditeur de texte à celle d'un environnement de développement intégré (IDE). ScraperWiki le reconnaît et offre à l'utilisateur un très grand choix quant à la façon dont vous écrivez votre code.

Si vous êtes si enclin, vous pouvez écrire votre code dans le navigateur. Comme vous pouvez vous y attendre de n'importe quel niveau professionnel, sur le Web Les 3 meilleurs IDE basés sur un navigateur pour coder dans le cloud Lire la suite outil de développement, il est livré avec des fonctionnalités que tout programmeur considérerait comme essentielles, telles que la coloration syntaxique.

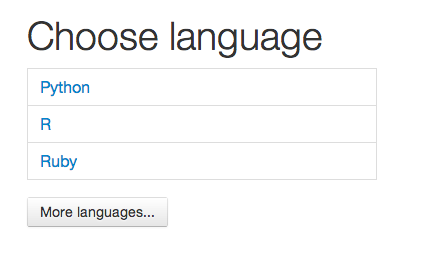

Plusieurs langues sont proposées. Ceux-ci inclus Python Les 5 meilleurs sites Web pour apprendre la programmation PythonVous voulez apprendre la programmation Python? Voici les meilleures façons d'apprendre Python en ligne, dont beaucoup sont entièrement gratuites. Lire la suite , un langage de script populaire utilisé par Google et la NASA; Rubis 3 façons interactives, amusantes et gratuites de commencer à apprendre le langage de programmation RubyRuby est un langage de script expressif de très haut niveau. Il est utilisé sur le Web principalement dans le cadre du cadre de développement Web Ruby on Rails, mais également de manière autonome. Si vous êtes curieux de savoir ce que Ruby (pas ... Lire la suite , qui alimente un certain nombre de sites Web populaires tels que Living Social; et le langage d'analyse statistique populaire, R.

De plus, vous pouvez également écrire du code à partir de la ligne de commande en utilisant SSH, Git et tout éditeur de texte que vous aimez utiliser. Oui, tu l'as bien lu. SSH Qu'est-ce que SSH et en quoi il diffère du FTP [Explication de la technologie] Lire la suite . Chaque boîte que vous utilisez est son propre compte Linux et vous pouvez vous y connecter comme vous le feriez avec un VPS ou tout autre compte shell. Plusieurs éditeurs de texte sont disponibles, notamment Vigueur Les 7 meilleures raisons de donner une chance à l'éditeur de texte VimPendant des années, j'ai essayé un éditeur de texte après l'autre. Vous l'appelez, je l'ai essayé. J'ai utilisé chacun de ces éditeurs pendant plus de deux mois comme mon principal éditeur au jour le jour. D'une certaine manière, je ... Lire la suite qui peut être étendu avec des plugins et en modifiant la configuration. Ceux qui sont intimidés par Vim peuvent utiliser Nano, un éditeur de texte léger en ligne de commande.

Les bibliothèques installées doivent être suffisantes pour écrire des outils permettant de récupérer des données et de les traiter. Si vous avez besoin de quelque chose d'un peu plus obscur, vous pouvez toujours créer un virtualenv à partir de la ligne de commande. Comme vous pouvez le voir, les développeurs disposent d'une grande flexibilité.

Visualisation de données

Donc, vous avez vos données. Vous l'avez normalisé. Vous l’avez nettoyé. Vous l'avez analysé. Il est maintenant temps de faire une visualisation et de montrer au monde ce que vous avez appris.

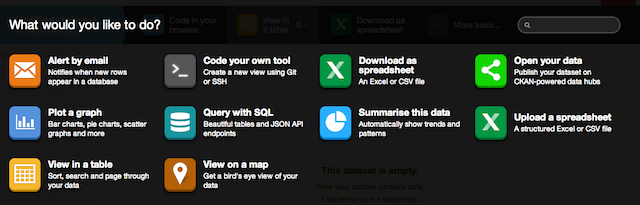

ScraperWiki permet aux développeurs d'afficher leurs données à l'aide de pages Web construites à partir du trifecta bien connu de HTML, CSS et JavaScript. De plus, les composants Bootstrap sont pris en charge immédiatement.

Il existe un certain nombre de visualisations prédéfinies disponibles, y compris celles qui tracent vos données sur une carte et trouvent des tendances dans vos résultats. Pour les utiliser, vous devez vous assurer que vos données sont stockées sous forme de fichier SQLite avec le nom de fichier «scraperwiki.sqlite». Ensuite, vous ajoutez simplement la visualisation qui vous intéresse. C'est simple, non?

Conclusion

ScraperWiki offre beaucoup aux développeurs qui souhaitent faire une analyse de données sans que leur environnement de développement ne les gêne, tout en ayant la flexibilité de satisfaire même les utilisateurs les plus exigeants. Mais qu'est ce que tu penses? Faites le moi savoir dans les commentaires ci-dessous.

Crédit photo: Science des fusées (Dan Brown)

Matthew Hughes est un développeur de logiciels et écrivain de Liverpool, en Angleterre. Il est rarement trouvé sans une tasse de café noir fort dans sa main et adore absolument son Macbook Pro et son appareil photo. Vous pouvez lire son blog sur http://www.matthewhughes.co.uk et suivez-le sur twitter à @matthewhughes.