Publicité

Au cours des derniers mois, vous avez peut-être lu la couverture entourant un article, co-écrit par Stephen Hawking, discutant des risques associés à l'intelligence artificielle. L'article suggérait que l'IA pouvait présenter un risque grave pour la race humaine. Hawking n'est pas seul là-bas - Elon Musk et Peter Thiel sont des personnalités intellectuelles publiques qui ont exprimé des préoccupations similaires (Thiel a investi plus de 1,3 million de dollars dans la recherche sur le problème et les solutions possibles).

La couverture de l'article de Hawking et les commentaires de Musk ont été, pour ne pas trop préciser, un peu joviaux. Le ton a été beaucoup "Regardez cette chose bizarre dont tous ces geeks sont inquiets." Peu de considération est accordée à l'idée que si certaines des personnes les plus intelligentes de la Terre vous avertissent que quelque chose pourrait être très dangereux, cela pourrait valoir la peine d'être écouté.

C'est compréhensible - l'intelligence artificielle qui envahit le monde semble certainement très étrange et invraisemblable, peut-être à cause de l'énorme attention déjà accordée à cette idée par la science-fiction écrivains. Alors, qu'est-ce qui a effrayé toutes ces personnes rationnellement sensées et rationnelles?

Qu'est-ce que l'intelligence?

Afin de parler du danger de l'intelligence artificielle, il pourrait être utile de comprendre ce qu'est l'intelligence. Afin de mieux comprendre le problème, examinons une architecture d'intelligence artificielle utilisée par les chercheurs qui étudient la théorie du raisonnement. Ce jouet AI est appelé AIXI et possède un certain nombre de propriétés utiles. Ses objectifs peuvent être arbitraires, il s’adapte bien à la puissance de calcul et sa conception interne est très claire et simple.

De plus, vous pouvez implémenter des versions simples et pratiques de l'architecture qui peuvent faire des choses comme jouer à Pacman, si tu veux. AIXI est le produit d'un chercheur en IA nommé Marcus Hutter, sans doute le plus grand expert en intelligence algorithmique. C'est lui qui parle dans la vidéo ci-dessus.

AIXI est étonnamment simple: il comprend trois composants principaux: apprenant, planificateur, et fonction d'utilité.

- le apprenant prend des chaînes de bits qui correspondent à une entrée sur le monde extérieur, et recherche dans les programmes informatiques jusqu'à ce qu'il trouve ceux qui produisent ses observations en sortie. Ces programmes, ensemble, lui permettent de deviner à quoi ressemblera l'avenir, simplement en exécutant chaque programme et pondérer la probabilité du résultat en fonction de la durée du programme (une mise en œuvre des Rasoir).

- le planificateur recherche parmi les actions possibles que l'agent pourrait entreprendre et utilise le module de l'apprenant pour prédire ce qui se passerait s'il entreprenait chacune d'entre elles. Il les évalue ensuite en fonction du bien ou du mal des résultats prévus et choisit le cours action qui maximise la qualité du résultat attendu multipliée par la probabilité attendue de y parvenir.

- Le dernier module, le fonction d'utilité, est un programme simple qui prend une description d'un état futur du monde et calcule un score d'utilité pour celui-ci. Ce score d'utilité est à quel point ce résultat est bon ou mauvais, et est utilisé par le planificateur pour évaluer l'état futur du monde. La fonction utilitaire peut être arbitraire.

- Pris ensemble, ces trois éléments forment un optimiseur, qui optimise pour un objectif particulier, quel que soit le monde dans lequel il se trouve.

Ce modèle simple représente une définition de base d'un agent intelligent. L'agent étudie son environnement, en construit des modèles, puis utilise ces modèles pour trouver le plan d'action qui maximisera les chances qu'il obtienne ce qu'il veut. AIXI est similaire dans sa structure à une IA qui joue aux échecs ou à d'autres jeux avec des règles connues - sauf qu'il est capable de déduire les règles du jeu en y jouant, à partir de zéro connaissance.

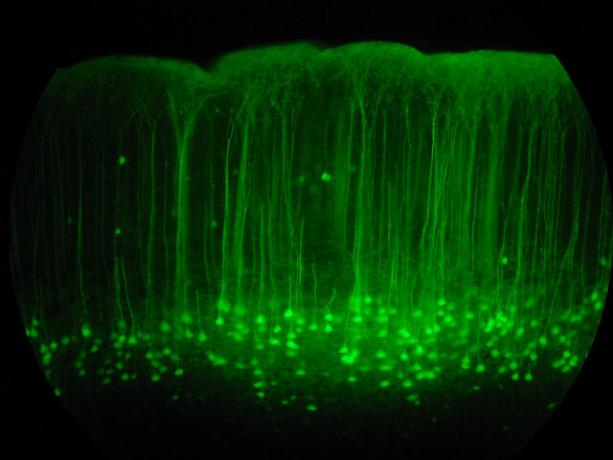

AIXI, avec suffisamment de temps pour calculer, peut apprendre à optimiser n'importe quel système pour n'importe quel objectif, aussi complexe soit-il. Il s'agit d'un algorithme généralement intelligent. Notez que ce n'est pas la même chose que d'avoir une intelligence humaine (l'IA d'inspiration biologique est un tout autre sujet Giovanni Idili d'OpenWorm: cerveaux, vers et intelligence artificielleLa simulation d'un cerveau humain est loin d'être terminée, mais un projet open source fait des premiers pas essentiels, en simulant la neurologie et la physiologie de l'un des animaux les plus simples connus de la science. Lire la suite ). En d'autres termes, AIXI peut être plus efficace que n'importe quel être humain à n'importe quelle tâche intellectuelle (avec une puissance de calcul suffisante), mais il pourrait ne pas être conscient de sa victoire Machines à penser: ce que la neuroscience et l'intelligence artificielle peuvent nous apprendre sur la conscienceLa construction de machines et de logiciels artificiellement intelligents peut-elle nous renseigner sur le fonctionnement de la conscience et la nature de l'esprit humain lui-même? Lire la suite .

En tant qu'IA pratique, AIXI a beaucoup de problèmes. Premièrement, il n'a aucun moyen de trouver les programmes qui produisent la sortie qui l'intéresse. Il s'agit d'un algorithme à force brute, ce qui signifie qu'il n'est pas pratique si vous ne disposez pas d'un ordinateur arbitrairement puissant. Toute implémentation réelle d'AIXI est nécessairement une approximation et (aujourd'hui) généralement assez grossière. Pourtant, AIXI nous donne un aperçu théorique de ce à quoi pourrait ressembler une puissante intelligence artificielle et comment elle pourrait raisonner.

L'espace des valeurs

Si vous avez fait de la programmation informatique Les bases de la programmation informatique 101 - Variables et types de donnéesAprès avoir présenté et parlé un peu de la programmation orientée objet avant et où son homonyme vient, je pensais qu'il était temps de passer par les bases absolues de la programmation dans un langage non spécifique façon. Ce... Lire la suite , vous savez que les ordinateurs sont littéralement odieux, pédantiquement et mécaniquement. La machine ne sait pas ou ne se soucie pas de ce que vous voulez qu'elle fasse: elle ne fait que ce qu'on lui a dit. C'est une notion importante lorsque l'on parle d'intelligence artificielle.

Dans cet esprit, imaginez que vous avez inventé une puissante intelligence artificielle - vous êtes venu avec des algorithmes intelligents pour générer des hypothèses qui correspondent à vos données et pour générer un bon candidat des plans. Votre IA peut résoudre des problèmes généraux et le faire efficacement sur du matériel informatique moderne.

Il est maintenant temps de choisir une fonction utilitaire, qui déterminera les valeurs de l'IA. Que devez-vous lui demander de valoriser? Rappelez-vous, la machine sera odieusement, littéralement pédante sur la fonction que vous lui demandez de maximiser, et ne s'arrêtera jamais - il n'y a pas de fantôme la machine qui se réveillera et décidera de changer sa fonction d'utilité, quel que soit le nombre d'améliorations de l'efficacité qu'elle apporte à la sienne raisonnement.

Eliezer Yudkowsky mets le comme ça:

Comme dans toute programmation informatique, le défi fondamental et la difficulté essentielle de AGI est que si nous écrivons le mauvais code, l'IA ne surveillera pas automatiquement notre code, ne marquera pas les erreurs, ne comprendra pas ce que nous voulions vraiment dire, et le fera au lieu. Les non-programmeurs imaginent parfois un AGI, ou des programmes informatiques en général, comme étant analogue à un serviteur qui suit les ordres sans aucun doute. Mais ce n'est pas que l'IA soit absolument obéissant à son code; plutôt, l'IA simplement est le code.

Si vous essayez de faire fonctionner une usine, et que vous dites à la machine de valoriser la fabrication de trombones, puis de lui donner le contrôle d'un tas de robots d'usine, vous pourrait revenir le lendemain pour constater qu'il a épuisé toutes les autres formes de matières premières, tué tous vos employés et fait des trombones de leur restes. Si, dans le but de corriger votre erreur, vous reprogrammer la machine pour simplement rendre tout le monde heureux, vous pouvez revenir le lendemain pour la trouver en train de mettre des fils dans le cerveau des gens.

Le point ici est que les humains ont beaucoup de valeurs compliquées que nous supposons partagées implicitement avec d'autres esprits. Nous valorisons l'argent, mais nous valorisons davantage la vie humaine. Nous voulons être heureux, mais nous ne voulons pas nécessairement mettre des fils dans notre cerveau pour le faire. Nous ne ressentons pas le besoin de clarifier ces choses lorsque nous donnons des instructions à d'autres êtres humains. Cependant, vous ne pouvez pas faire ce genre d'hypothèses lorsque vous concevez la fonction d'utilité d'une machine. Les meilleures solutions dans le cadre du calcul sans âme d'une simple fonction d'utilité sont souvent des solutions que les êtres humains jugeraient moralement horribles.

Permettre à une machine intelligente de maximiser une fonction utilitaire naïve sera presque toujours catastrophique. Comme le dit le philosophe d'Oxford Nick Bostom,

Nous ne pouvons pas alléguer allègrement qu'une superintelligence partagera nécessairement l'une des valeurs finales stéréotypées associées à la sagesse et le développement intellectuel chez l'homme - curiosité scientifique, souci bienveillant des autres, illumination spirituelle et contemplation, renoncement à l'acquisition matérielle, goût de la culture raffinée ou des plaisirs simples de la vie, humilité et altruisme, et ainsi de suite.

Pour aggraver les choses, il est très, très difficile de spécifier la liste complète et détaillée de tout ce que les gens apprécient. Il y a beaucoup de facettes à la question, et oublier même une seule est potentiellement catastrophique. Même parmi ceux que nous connaissons, il y a des subtilités et des complexités qui rendent difficile de les écrire comme des systèmes d'équations propres que nous pouvons donner à une machine comme fonction d'utilité.

Certaines personnes, en lisant ceci, concluent que la création d'IA avec des fonctions utilitaires est une idée terrible, et nous devrions simplement les concevoir différemment. Ici, il y a aussi de mauvaises nouvelles - vous pouvez prouver, formellement, que tout agent qui n'a pas quelque chose d'équivalent à une fonction utilitaire ne peut pas avoir de préférences cohérentes à propos du futur.

Auto-amélioration récursive

Une solution au dilemme ci-dessus consiste à ne pas donner aux agents de l'IA la possibilité de blesser les gens: ne leur donnez que les ressources dont ils ont besoin pour Résolvez le problème de la manière dont vous voulez qu'il soit résolu, surveillez-le de près et éloignez-le des opportunités nuire. Malheureusement, notre capacité à contrôler des machines intelligentes est hautement suspecte.

Même s'ils ne sont pas beaucoup plus intelligents que nous, la machine a la possibilité de «démarrer» - collecter un meilleur matériel ou apporter des améliorations à son propre code qui le rend encore plus intelligent. Cela pourrait permettre à une machine de dépasser l'intelligence humaine de plusieurs ordres de grandeur, surpassant les humains dans le même sens que les humains surpassent les chats. Ce scénario a d'abord été proposé par un homme nommé I. J. Good, qui a travaillé sur le projet d'analyse de cryptes Enigma avec Alan Turing pendant la Seconde Guerre mondiale. Il a appelé cela une «explosion du renseignement» et a décrit la question comme suit:

Qu'une machine ultra-intelligente soit définie comme une machine qui peut dépasser de loin toutes les activités intellectuelles de tout homme, aussi intelligent soit-il. La conception de machines étant l'une de ces activités intellectuelles, une machine ultra-intelligente pourrait concevoir des machines encore meilleures; il y aurait alors incontestablement une «explosion du renseignement», et l'intelligence de l'homme serait laissée loin derrière. Ainsi, la première machine ultra-intelligente est la dernière invention que l'homme ait besoin de faire, à condition que la machine soit suffisamment docile.

Il n'est pas garanti qu'une explosion d'intelligence soit possible dans notre univers, mais cela semble probable. Au fil du temps, les ordinateurs obtiennent des informations plus rapides et de base sur le renforcement de l'intelligence. Cela signifie que les ressources nécessaires pour effectuer ce dernier saut vers une intelligence générale et boostrapping diminuent de plus en plus. À un moment donné, nous nous retrouverons dans un monde dans lequel des millions de personnes peuvent se rendre chez Best Buy et récupérer le matériel et la littérature technique dont ils ont besoin pour construire une intelligence artificielle qui s'améliore, que nous avons déjà établie peut être très dangereux. Imaginez un monde dans lequel vous pourriez fabriquer des bombes atomiques avec des bâtons et des roches. C’est le genre d’avenir dont nous discutons.

Et, si une machine fait ce saut, elle pourrait très rapidement dépasser l'espèce humaine en termes de productivité, résolvant des problèmes qu’un milliard d’humains ne peuvent pas résoudre, de la même manière que les humains peuvent résoudre des milliards de chats ne peuvent pas.

Il pourrait développer des robots puissants (ou bio ou nanotechnologie) et gagner relativement rapidement la capacité de remodeler le monde à sa guise, et nous ne pourrions pas faire grand-chose à ce sujet. Une telle intelligence pourrait dépouiller la Terre et le reste du système solaire de pièces détachées sans trop de problèmes, en route pour faire tout ce que nous lui avons dit. Il semble probable qu'un tel développement serait catastrophique pour l'humanité. Une intelligence artificielle n’a pas besoin d’être malveillante pour détruire le monde, elle est simplement catastrophiquement indifférente.

Comme dit le proverbe: "La machine ne vous aime pas ou ne vous déteste pas, mais vous êtes fait d'atomes qu'elle peut utiliser pour d'autres choses."

Évaluation et atténuation des risques

Donc, si nous acceptons que la conception d'une puissante intelligence artificielle qui maximise une simple fonction d'utilité est mauvaise, dans quel problème sommes-nous vraiment? Combien de temps avons-nous avant qu'il ne soit possible de construire ce genre de machines? C'est, bien sûr, difficile à dire.

Les développeurs d'intelligence artificielle sont faire des progrès. 7 sites Web incroyables pour voir les dernières nouveautés en programmation d'intelligence artificielleL'intelligence artificielle n'est pas encore HAL de 2001: l'Odyssée de l'espace… mais nous nous rapprochons terriblement. Effectivement, un jour, cela pourrait être aussi similaire aux chaudières de science-fiction produites par Hollywood ... Lire la suite Les machines que nous construisons et les problèmes qu'elles peuvent résoudre n'ont cessé de croître. En 1997, Deep Blue pouvait jouer aux échecs à un niveau supérieur à celui d'un grand maître humain. En 2011, Watson d'IBM a pu lire et synthétiser suffisamment d'informations en profondeur et assez rapidement pour battre le meilleur humain joueurs à un jeu de questions-réponses ouvert criblé de jeux de mots et de mots - c'est beaucoup de progrès en quatorze années.

En ce moment, Google est investir massivement dans la recherche sur l'apprentissage en profondeur, une technique qui permet la construction de réseaux neuronaux puissants en construisant des chaînes de réseaux neuronaux plus simples. Cet investissement lui permet de faire de sérieux progrès dans la reconnaissance de la parole et des images. Leur acquisition la plus récente dans la région est une startup du Deep Learning appelée DeepMind, pour laquelle ils ont payé environ 400 millions de dollars. Dans le cadre des termes de l'accord, Google a accepté de créer un comité d'éthique pour s'assurer que leur technologie d'IA est développée en toute sécurité.

Dans le même temps, IBM développe Watson 2.0 et 3.0, des systèmes capables de traiter des images et des vidéos et de défendre des conclusions. Ils ont donné une démo simple et précoce de la capacité de Watson à synthétiser des arguments pour et contre un sujet dans la démo vidéo ci-dessous. Les résultats sont imparfaits, mais une étape impressionnante malgré tout.

Aucune de ces technologies n'est en soi dangereuse en ce moment: l'intelligence artificielle en tant que domaine a encore du mal à correspondre aux capacités maîtrisées par les jeunes enfants. La programmation informatique et la conception de l'IA sont des compétences cognitives de haut niveau très difficiles, et seront probablement la dernière tâche humaine pour laquelle les machines deviennent compétentes. Avant d'en arriver là, nous aurons également des machines omniprésentes qui peut conduire Voici comment nous arriverons dans un monde rempli de voitures sans conducteurLa conduite est une tâche fastidieuse, dangereuse et exigeante. Pourrait-il un jour être automatisé par la technologie de voiture sans conducteur de Google? Lire la suite , pratiquer la médecine et le droit, et probablement d'autres choses également, avec de profondes conséquences économiques.

Le temps qu'il nous faudra pour arriver au point d'inflexion de l'auto-amélioration dépend juste de la vitesse à laquelle nous avons de bonnes idées. Il est notoirement difficile de prévoir les progrès technologiques de ce type. Il ne semble pas déraisonnable que nous soyons en mesure de construire une IA solide dans vingt ans, mais il ne semble pas non plus déraisonnable que cela prenne quatre-vingts ans. Quoi qu'il en soit, cela finira par arriver, et il y a des raisons de croire que lorsque cela se produira, ce sera extrêmement dangereux.

Donc, si nous acceptons que cela va être un problème, que pouvons-nous faire? La réponse est de s'assurer que les premières machines intelligentes sont sûres, afin qu'elles puissent démarrer jusqu'à un niveau significatif d'intelligence, puis nous protéger des machines dangereuses fabriquées plus tard. Cette «sécurité» est définie par le partage des valeurs humaines et la volonté de protéger et d'aider l'humanité.

Parce que nous ne pouvons pas réellement nous asseoir et programmer des valeurs humaines dans la machine, il sera probablement nécessaire de concevoir une fonction utilitaire qui nécessite que la machine observer les humains, déduire nos valeurs, puis essayer de les maximiser. Afin de sécuriser ce processus de développement, il peut également être utile de développer des intelligences artificielles spécifiquement conçues ne pas d'avoir des préférences sur leurs fonctions utilitaires, ce qui nous permet de les corriger ou de les désactiver sans résistance s'ils commencent à s'égarer pendant le développement.

Beaucoup de problèmes que nous devons résoudre pour construire une intelligence de machine sûre sont difficiles mathématiquement, mais il y a des raisons de croire qu'ils peuvent être résolus. Un certain nombre d'organisations différentes travaillent sur la question, y compris le Future of Humanity Institute à Oxford, et le Institut de recherche Machine Intelligence (que Peter Thiel finance).

MIRI s'intéresse spécifiquement au développement des mathématiques nécessaires à la création d'une IA conviviale. S'il s'avère que l'amorçage de l'intelligence artificielle est possible, développer ce type de La technologie «Friendly AI» en premier, si elle réussit, peut devenir la chose la plus importante que les humains aient jamais fait.

Pensez-vous que l'intelligence artificielle est dangereuse? Êtes-vous préoccupé par ce que l'avenir de l'IA pourrait apporter? Partagez vos pensées dans la section des commentaires ci-dessous!

Crédits image: Lwp Kommunikáció Via Flickr, “Réseau neuronal", Par fdecomite," img_7801", Par Steve Rainwater," E-Volve ", par Keoni Cabral,"new_20x", Par Robert Cudmore,"Trombones», Par Clifford Wallace

Écrivain et journaliste basé dans le sud-ouest, André est assuré de rester fonctionnel jusqu'à 50 degrés Celsius et est étanche jusqu'à une profondeur de douze pieds.